1、robot.txt它是一个文件,通过这个文件中的文本来告诉搜索引擎,哪个目录,哪个页面不愿意被收录。例如,你网站的后台,一些有密码保护的内容你不希望被搜索引擎收录。你就可以利用robot.txt,来做到不让搜索引擎收录。

2、在一个站点上只能有一个 /robots.txt 文件,而且文件名的每个字母要求全部是小 写。在Robot的记录格式中每一个单独的Disallow行表示你不希望Robot访问的URL, 每个URL必须单独占一行,不能出现 Disallow: /cgi-bin/ /tmp/这样的病句。同时在一个记录中不能出现空行,这是因为空行是多个记录分割的标志。

3、robots.txt是搜索引擎中访问网站的时候要查看的之一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

4、robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。

5、robots.txt就是一个记事本文件(txt格式文件),存放在网站根目录下。那么robots.txt语法到底有哪些呢?robots.txt语法有三个语法和两个通配符。三个语法:首先要定义网站被访问的搜索引擎是那些。

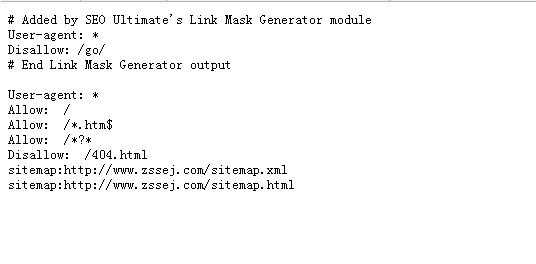

6、robot.txt文件的详细使用教程 第二个我们要熟悉的就是Disallow,这项值是用来描述不希望被搜索机器人访问到网址。这个网址可以是完整的路径,也就是域名加上目录名或者文件名的格式,也可以是相对,也就是除去了域名,只有文件名或者目录名。

这个文件是针对搜索引擎设置的文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。 Disallow:这个词就是禁止搜索引擎访问的意思。

robots.txt是搜索引擎中访问网站的时候要查看的之一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

因为robots.txt只是给搜索引擎蜘蛛爬去做限制的,告诉蜘蛛哪些文件夹或路径不要去爬取。

什么是robots.txt文件? 搜索引擎通过一种程序robot(又称spider),自动访问互联网上的网页并获取网页信息。 您可以在您的网站中创建一个纯文本文件robots.txt,在这个文件中声明该网站中不想被robot访问的部分,这样,该网站的部分或全部内容就可以不被搜索引擎收录了,或者指定搜索引擎只收录指定的内容。

应该是robots.txt文件吧,robots.txt是搜索引擎中访问网站的时候要查看的之一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。robots.txt 是一个纯文本文件,在这个文件中网站管理者可以声明该网站中不想被robots访问的部分,或者指定搜索引擎只收录指定的内容。

搜索引擎爬去我们页面的工具叫做搜索引擎机器人,也生动的叫做“蜘蛛”蜘蛛在爬去网站页面之前,会先去访问网站根目录下面的一个文件,就是robots.txt。这个文件其实就是给“蜘蛛”的规则,如果没有这个文件,蜘蛛会认为你的网站同意全部抓取网页。

1、robots是一个协议,是建立在网站根目录下的一个以(robots.txt)结尾的文本文件,对搜索引擎蜘蛛的一种限制指令。是蜘蛛程序爬行网站之一个要访问抓取的页面,网站可以通过robots协议来告诉搜索引擎蜘蛛程序哪些页面可以抓取,哪些页面不可以抓取。

2、该网站用robots指令屏蔽了搜索引擎的抓取。

3、这个文件是针对搜索引擎设置的文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。 Disallow:这个词就是禁止搜索引擎访问的意思。

1、User杠agent:Disallow:或者User杠agent:Allow允许所有搜索引擎访问网站的所有部分。Disallow说明允许robot访问该网站的所有url,在robots.txt文件中,至少要有一条Disallow记录访问。

2、Disallow: 说明允许 robot 访问该网站的所有 url,在 /robots.txt 文件中,至少要有一条 Disallow 记录。如果 /robots.txt 不存在或者为空文件,则对于所有的搜索引擎 robot,该网站都是开放的。

3、(1),允许所有的搜索引擎访问网站的所有部分或者建立一个空白的文本文档,命名为robots.txt。User-agent:*Disallow:或者User-agent:*Allow:/ (2),禁止所有搜索引擎访问网站的所有部分。User-agent:*Disallow:/ (3),禁止百度索引你的网站。

1、如果你想了解dz论坛(Discuz论坛)的Robots.txt设置,你可以采取以下步骤: 登录dz论坛的后台管理系统。 导航到“论坛设置”或类似的选项。 在设置选项中找到“Robots文件”或相关的设置选项。 打开这个选项,你会看到一个文本框或文本编辑器,其中显示了当前的Robots.txt内容。

2、robots.txt必须放置在一个站点的根目录下,而且文件名必须全部小写。

3、首先,我们需要创建一个robots.txt文本文件,然后在文档内设置好代码,告诉搜索引擎我网站的哪些文件你不能访问。然后上传到网站根目录下面,因为当搜索引擎蜘蛛在索引一个网站时,会先爬行查看网站根目录下是否有robots.txt文件。

4、robots.txt写作语法首先,我们来看一个robots.txt范例:robots.txtfilestart#Robots.txtfilefrom http:// -agent:*Disallow:/security/Disallow:/admin/Disallow:/admin.htm#Endrobots.txtfile 有#号的都是注释,方便阅读。

在服务器的根目录下,创建一个新的robots.txt文件,添加不希望蜘蛛爬行的目录:写作 *** 如果您站点中的所有文件都可以被蜘蛛抓取和包含,那么语法如下所示:用户 *** :*Disallow:当然,如果你网站中的所有文件都可以被搜索引擎索引,你可以不去管这个文件。

可以屏蔽的,你写的robots协议也没问题。在各个搜索引擎的站长平台,提交以下死链,以后那个页面他们就不会收录了。让你们的程序员,做个跳转。可以跳转到首页,栏目页。希望我的回答可以帮助到你,如果还有什么不懂,可以追问或私信我。

通配符:告诉蜘蛛匹配任意一段字符,是任意一段字符,我想像你那两种设置应该都可以。

语法:User-agent: * 或 搜索引擎的蜘蛛名称 例子:User-agent:Googlebot (定义谷歌,只允许谷歌蜘蛛爬取)User-agent:Baiduspider (定义百度,只允许百度蜘蛛爬取)User-agent:*(定义所有搜索引擎)2:屏蔽搜索引擎爬去语法 Disallow禁止语法) 用来定义禁止蜘蛛爬取的页面或目录。