1、robot.txt ,主要是屏蔽作用和加权作用,比如一些搜录的,但是现在你这个文章地址没有了,就要屏蔽,有些admin 和一些目录你不想让百度来搜,也是屏蔽 。

2、robot.txt文件中也只有这两个属性了,只要掌握了这两个属性的用法,我们就可以根据自己网站的情况自定义robot.txt文件了,如果你的robot.txt文件没弄好,或出错了,会影响整个网站的收录,所以自定义robot文件的时候还需要格外注意。

3、百度无法抓取网站,因为其robots.txt文件屏蔽了百度。 *** :修改robots文件并取消对该页面的阻止。机器人的标准写法详见百度百科:网页链接。更新百度站长平台(更名为百度资源平台)上的网站机器人。过一段时间,你的网站会被正常抓取收录。

4、robot.txt的主要功能 有人会问,既然robots文件没有准备好,或者出现了错误,会影响整个网站的收录,为什么还要这个文件呢?其实robots是给有特殊情况的站长用的,因为有些网站有一些站长不希望被任何搜索引擎收录的页面,所以这个robots文件是有的。

5、robot.txt它是一个文件,通过这个文件中的文本来告诉搜索引擎,哪个目录,哪个页面不愿意被收录。例如,你网站的后台,一些有密码保护的内容你不希望被搜索引擎收录。你就可以利用robot.txt,来做到不让搜索引擎收录。

robots是英语中的一个词汇,意思是“机器人(们)”。在计算机科学中,“robots.txt”是一种文件格式,一般位于一个网站的根目录,用来告诉搜索引擎爬虫访问该网站时应该遵守哪些规则,例如哪些页面应该被允许抓取,哪些页面不应该抓取等。

robots.txt文件是一个文本文件,使用任何一个常见的文本编辑器,比如Windows系统自带的Notepad,就可以创建和编辑它。robots.txt是一个协议,而不是一个命令。robots.txt是搜索引擎中访问网站的时候要查看的之一个文件。robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

搜索引擎爬去我们页面的工具叫做搜索引擎机器人,也生动的叫做“蜘蛛”蜘蛛在爬去网站页面之前,会先去访问网站根目录下面的一个文件,就是robots.txt。这个文件其实就是给“蜘蛛”的规则,如果没有这个文件,蜘蛛会认为你的网站同意全部抓取网页。

在robots.txt中,键后面加:号,后面必有一个空格,和值相区分开。2)Disallow键 该键用来说明不允许搜索引擎蜘蛛抓取的URL路径。

屏蔽网站内的死链接。屏蔽搜索引擎蜘蛛抓取站点内重复内容和页面。阻止搜索引擎索引网站隐私性的内容。(例如用户账户信息等)Robots.txt放在哪?robots.txt 文件应该放置在网站根目录下(/robots.txt)。

robots.txt是搜索引擎中访问网站的时候要查看的之一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

robots文件主要的作用就是阻止蜘蛛抓取你不想让他抓取的文件。更好还是要一个,比如网站后台等一些文件 想要不被他他抓取,robots文件就能起到作用了。

Disallow: /*.xls$您可将此模式匹配与 Allow 指令配合使用。例如,如果 ? 代表一个会话 ID,那么您可能希望排除包含 ? 的所有网址,以确保 Googlebot 不会抓取重复网页。但是以 ? 结尾的网址可能是您希望包含在内的网页的版本。

它会首先检查该站点根目录下是否存在robots.txt,如果存在,就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。robot.txt文件的详细使用教程 了解了它的用途之后,我们就可以深入的研究下这个文件了。

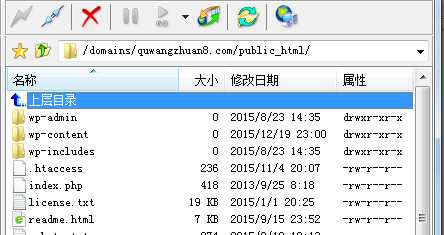

robots.txt文件应该放在网站根目录下。举例来说,当搜索引擎 访问一个网站时,首先会检查该网站中是否存在robots.txt这个文件,如果robots机器人程序找到这个文件,它就会根据这个文件的内容,来确定它访问权限的范围。

在“robots.txt”文件中,如果有多条 User-agent记录,说明有多个robot会受到该协议的约束。所以,“robots.txt”文件中至少要有一条User- agent记录。如果该项的值设为*(通配符),则该协议对任何搜索引擎机器人均有效。在“robots.txt”文件 中,“User-agent:*”这样的记录只能有一条。

robotstudio的文件在其他电脑打不开原因:没有控制指令发出,控制器的问题,根本接收不到控制指令。

可能是您那边的浏览器问题,换成360或者火狐的其它浏览器尝试一下。如果还不行的话,您看下它那个网站里面有没有反馈的地方,联系它的 *** 或者打 *** 反馈问询一下,也可以发给您朋友帮忙测试下。看是否真的是遇到同样的问题。如果确实这样。

如果 /robots.txt 不存在或者为空文件,则对于所有的搜索引擎 robot,该网站都是开放的。Allow:该项的值用于描述希望被访问的一组 URL,与 Disallow 项相似,这个值可以是一条完整的路径,也可以是路径的前缀,以 Allow 项的值开头的 URL 是允许 robot 访问的。

因为robots.txt只是给搜索引擎蜘蛛爬去做限制的,告诉蜘蛛哪些文件夹或路径不要去爬取。

Robots.txt文件的作用:屏蔽网站内的死链接。屏蔽搜索引擎蜘蛛抓取站点内重复内容和页面。阻止搜索引擎索引网站隐私性的内容。

robots.txt是搜索引擎中访问网站的时候要查看的之一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。robots.txt 是一个纯文本文件,在这个文件中网站管理者可以声明该网站中不想被robots访问的部分,或者指定搜索引擎只收录指定的内容。

另外,robots.txt主要用于保证网络安全和网站隐私,百度蜘蛛遵循robots.txt协议。通过根目录下创建的纯文本文件robots.txt,网站可以声明哪些页面不想被百度蜘蛛抓取收录。每个网站可以自主控制网站是否愿意被百度蜘蛛收录,或者指定百度蜘蛛只收录指定的内容。

robots.txt也可用在某一目录中。对这一目录下的文件进行搜索范围设定。几点注意:网站必须要有一个robot.txt文件。文件名是小写字母。当需要完全屏蔽文件时,需要配合meta的robots属性。robots.txt的基本语法 内容项的基本格式:键: 值对。

搜索引擎爬去我们页面的工具叫做搜索引擎机器人,也生动的叫做“蜘蛛”蜘蛛在爬去网站页面之前,会先去访问网站根目录下面的一个文件,就是robots.txt。这个文件其实就是给“蜘蛛”的规则,如果没有这个文件,蜘蛛会认为你的网站同意全部抓取网页。

robots.txt是搜索引擎中访问网站的时候要查看的之一个文件。Robots.txt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的。

robots.txt文件包含一条或更多的记录,这些记录通过空行分开(以CR,CR/NL, or NL作为结束符),每一条记录的格式如下所示: field:optionalspacevalueoptionalspace。在该文件中可以使用#进行注解,具体使用 *** 和UNIX中的惯例一样。

百度百科: robots协议也叫robots.txt (统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的。